最近工作中在拆分ES大索引,有使用到一个python脚本,引用了如下的库,记录一下CentOS7中如何只使用yum安装如下的库。 from elasticsearch import Elasticsearch from dateutil.parser import * from dateutil.relativedelta import relativedelta 报错提示 from elasticsearch import Elasticsearch ImportError: No module named el…

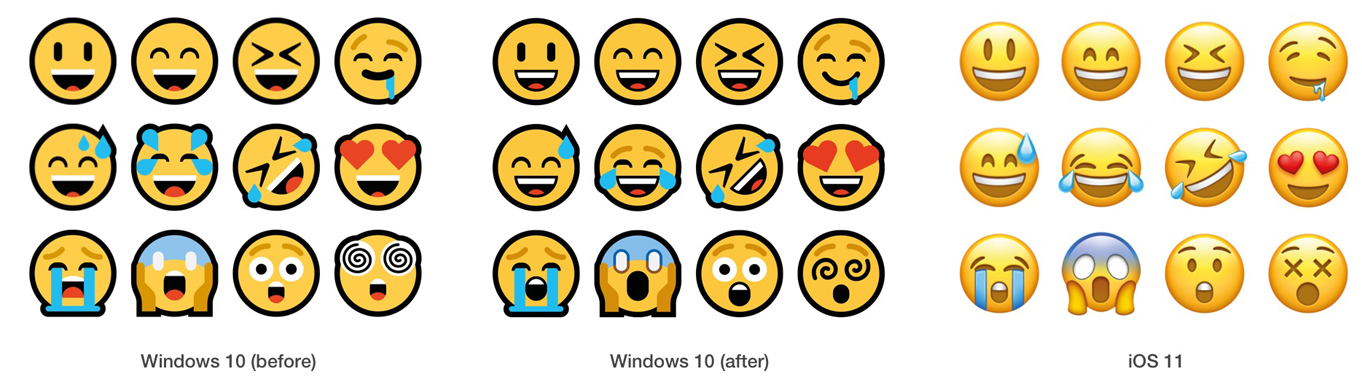

最近项目中使用load file导入文件到低版本MySQL中遇到卡住问题,最终问题为文本文件中某些行包含了emoji表情符号。所以使用python去掉这个emoji符号,然后再导出数据库。 需要安装如下模块: https://pypi.org/project/demoji/ 安装完demoji模块后需要手动下载emoji json文件,如果服务器无法上网,可以本地电脑运行,然后提取这个codes.json文件上传到服务器对应的目录。 代码如下:

近日朋友向我求助说是在CentOS6中编译安装了python2.7后面不知怎么搞的yum也用不了的,本以为很简单的事情,把yum里的头替换一下就好了,结果事情不是那个简单。 参考这篇文章重装 https://www.lizenghai.com/archives/17330.html,所使用的包如下: 下面这些是一些记录,看不懂可忽略这一段 rpm -qa|grep python|xargs rpm -ev --allmatches --nodeps ##强制清除已安装的程序及其关联 whereis python |…

haprox external-check 健康检测可以自定义脚本来检测后端服务,这非常有利于那些经常出现假死,无法通过常规判断端口来检测后台是否正常的问题。 比如,RabbitMQ,业务程序自定义检查等。 HAProxy可以使用二进制或脚本运行外部命令来执行运行状况检查。 当这样做的时候,它需要将自己fork一个新进程。 如果您使用chroot,请确保该命令及其所有依赖项在chroot中可用。 以下指令可用: In the global section: external-check: Allows the us…

说话一个GM后台开服信息需要手动在GM后台提交,这个手动做了3个月,终于忍不了重复劳动,手动输入造成漏填及填错的问题。亮出 Python 中的 requests 模块,听说用这个写爬虫不错,palapala 很快脚本可以从文件读取相关配置信息,并能登陆后台获取 session,并提交上数据。但问题出现了,其中有个开服日期(2016-03-08 14:00:00 这种 "yyyy-MM-dd HH:mm:ss"格式)没有保存到数据库中,期间使用各种工具抓包对比浏览器手动提交的post参数均没发现问题,用 Postma…

在 Ubuntu 14.04.1 LTS 桌面系统里安装了 pycharm-4.5.4,Linux 下的 pycharm 是通过 java 来运行的,所以需要安装 Java jdk. 安装命令很简单 Tornado 是 FriendFeed 使用的可扩展的非阻塞式 web 服务器及其相关工具的开源版本。这个 Web 框架看起来有些像web.py 或者 Google 的 webapp,不过为了能有效利用非阻塞式服务器环境,这个 Web 框架还包含了一些相关的有用工具 和优化。 Tornado 和现在的主流 Web 服…

关于Python脚本开头 # -*- coding: utf-8 -*- 的作用 1 指定文件编码类型 是用来说明脚本语言是python的是要用/usr/bin下面的程序(工具)python,这个解释器,来解释python脚本,来运行python脚本的。 推荐使用下面这个 2 # -*- coding: utf-8 -*- 是用来指定文件编码为utf-8的,详情可以参考: PEP 0263 — Defining Python Source Code Encodings 在此,详细的(主要是翻译)解释一…

Django seetings.py配置文件中默认没有 APPEND_SLASH 这个参数,但 Django 默认这个参数为 APPEND_SLASH = True。 作用就是自动在网址结尾加'/'。 如下URL视图: 因定义了hello/结尾: 默认地,任何不匹配或尾部没有斜杠(/)的申请URL,将被重定向至尾部包含斜杠的相同字眼的URL。 当 seetings.py 设置为 APPEND_SLASH = False 时,访问 http://example.com/hello 将会返回 404。 所以我觉得还是按…

python 中的is、==和cmp(),比较字符串 经常写 shell 脚本知道,字符串判断可以用 =,!= 数字的判断是 -eq,-ne 等,但是 Python 确不是这样子地。 所以作为慢慢要转换到用 Python 写脚本,这些基本的东西必须要掌握到骨子里! 在 Python 中比较字符串最好是使用简单逻辑操作符。 例如,确定一个字符串是否和另外一个字符串匹配。正确的,你可以使用 is equal 或 == 操作符。你也可以使用例如 >= 或 < 来确定几个字符串的排列顺序。 从官方文档上看 也就…

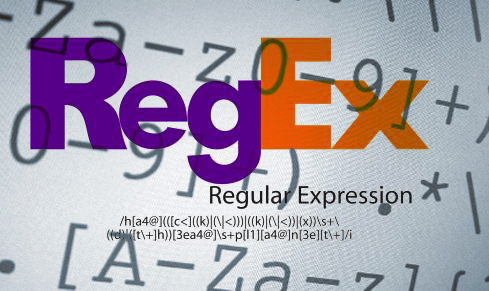

1. 正则表达式基础 1.1. 简单介绍 正则表达式并不是Python的一部分。正则表达式是用于处理字符串的强大工具,拥有自己独特的语法以及一个独立的处理引擎,效率上可能不如str自带的方法,但功能十分强大。得益于这一点,在提供了正则表达式的语言里,正则表达式的语法都是一样的,区别只在于不同的编程语言实现支持的语法数量不同;但不用担心,不被支持的语法通常是不常用的部分。如果已经在其他语言里使用过正则表达式,只需要简单看一看就可以上手了。 下图展示了使用正则表达式进行匹配的流程: 正则表达式的大致匹配过程是:依次拿出…

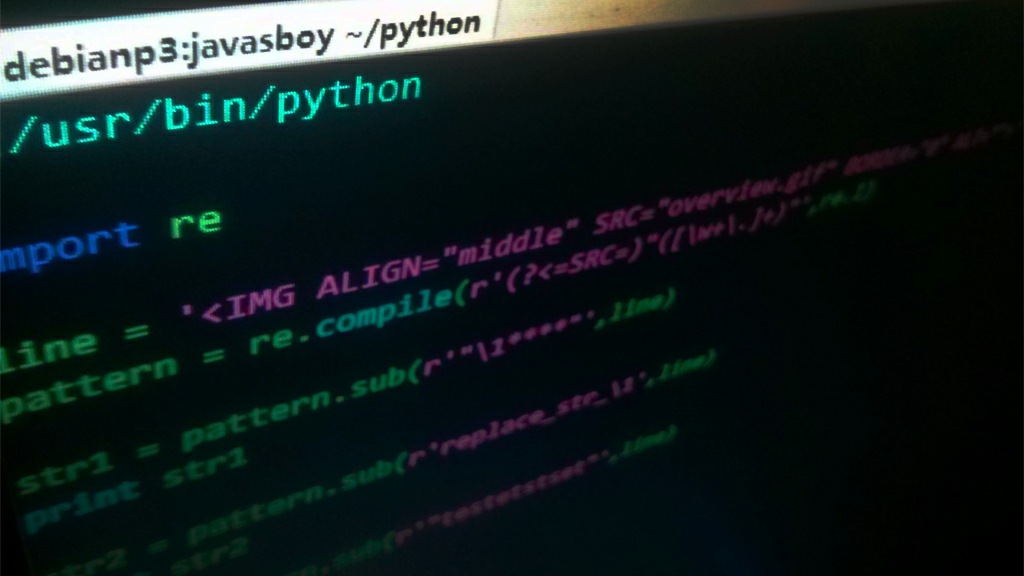

今天下班途中,在我的 Pocket 列表中看到前些天丢进来的《Python编程中常用的12种基础知识总》一文中的第一个例子: 正则表达式替换。 目标: 将字符串 line 中的 overview.gif 替换成其他字符串 随便分析了一下,感觉不通顺,虽想回家好好分析下,结果掉一坑里去了。文中例子代码丢失一段,导致我想了半天都没想去为啥就要这样匹配,后来机智的我想到肯定是代码不全,Google 了下找到了。在这里鄙视下那些 Ctrl C,Ctrl V 的,万一一个启动脚本里有个 rm -rf / tmp/xxx 那不…